Reakcja botów była natychmiastowa

Atak aktorów wpływu, czyli fałszywych kont skoordynowanych wokół spójnego zadania informacyjnego, zaczął się już ok. 10 sekund po opublikowaniu wywiadu „KW” z korespondentem wojennym Tomášem Forró.

Czas powstawania, natłok i objętość publikowanych komentarzy natychmiast dał redakcji do zrozumienia, że to nie mogą być zwykli czytelnicy. Redakcyjni moderatorzy wdrożyli 11-punktową weryfikację komentujących kont.

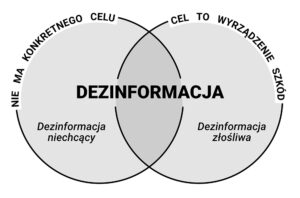

Wspomniany kwestionariusz, przygotowany przez redakcję na podstawie ekspertyz jak i redakcyjnego ponaddwudekadowego doświadczenia, pozwala określić stopień prawdopodobieństwa, czy konto należy do prawdziwej osoby, czy jest tzw. botem. Bot to połowicznie lub całkowicie zautomatyzowane konto, które działa w zgodzie z algorytmem przygotowanym przez swojego właściciela.

Czym jest jednostka 54777 GRU?

Rosyjskimi botami zarządza najczęściej (choć nie tylko) jednostka GRU 54777, której istnienie udało się w przeszłości potwierdzić także ustami Kremla.

To wyspecjalizowana jednostka rosyjskiego GRU (służb bezpieczeństwa), która zajmuje się m.in. tzw. operacjami psychologicznymi i stanowi element doktryny pt. „wojna informacyjna”. O tej grupie pisał m.in. polski portal specjalistów od cyberbezpieczeństwa, CyberDefence24.pl na podstawie prywatnej firmy wywiadowczej, Grey Dynamics.

Treści botów były przygotowywane według narracji ustalonej przez specjalistów i powielały narracje Kremla. Jednak automatyczny lub półautomatyczny algorytm rosyjskich botów niepoprawnie rozpoznał target (czyli docelowych odbiorców). Treści komentarzy były przeznaczone na rynek w Polsce. Po czasie algorytm „zorientował się”, że jesteśmy gazetą na Litwie, wtedy boty zaczęły publikować komentarze po rosyjsku i litewsku (choć w tym przypadku — z hinduskich kont). Jednak ich treść nie była dopasowana do komentowanego kontekstu. Po dwóch dniach moderacji dyskusji, atak ustał.

Od kiedy rosyjskie trolle zostały zoptymalizowane pod względem kosztów i zintegrowane ze sztuczną inteligencją, są bardziej masowe, ale jednocześnie… „głupsze” — choć to oczywiście kwestia czasu. Rzadziej niż kiedyś wchodzą w dyskusję, znikają po pojedynczym wpisie. Rzadziej też dopasowują się do kontekstu dyskusji w komentarzach, ograniczają się do analizy treści samego wpisu (postu). Wciąż źle odczytują tekst, który jest częścią zdjęcia. Wynika to z tego, że już bardzo rzadko za trollerskim kontem siedzi żywy człowiek.

Czego nie weryfikuje kwestionariusz

Weryfikacji nie podlegały prezentowane przez komentujących poglądy, a tylko prawdziwość profili, co zresztą nasi Czytelnicy mogli i mogą sprawdzić sami. Redakcja „KW” od lat mierzy się z atakami trolli jak i hakerów i ma w tym bogate doświadczenie.

Czytaj także: Dlaczego Rosjanie nie ukrywają, a wręcz chwalą się zbrodniami wojennymi?

Niestety, widzimy stale rosnącą liczbę fałszywych kont i bezczynność platform, które na nich zarabiają (ruch można sprzedać reklamodawcom). Co więcej, socmedia wręcz zachęcają do tworzenia fałszywych kont. Prezentują na stronie instrukcje, jak postępować, aby nikt nie powiązał fałszywego konta z właścicielem. To działanie nieetyczne, ale niestety nikt nie jest zainteresowany zmianą prawodawstwa w tej materii ani w Europie, ani na Litwie, gdyż nie ma w tym łupu politycznego. Tak samo nieetyczne jest posługiwanie się przez rosyjskie boty zdjęciami i tożsamościami osób zmarłych, co miało miejsce nawet podczas opisywanego ataku.

Z niepokojem obserwujemy, że takie ataki nie na wszystkich profilach na Litwie są moderowane. O ile natłok takich komentarzy zwiększa zasięg naszego wpisu, to jest to korzyść złudna. Opublikowany materiał staje się wtedy „nośnikiem” dla takich botów, co pozwala skutecznie zwiększać napięcie społeczne.

Apolinary Klonowski, kierownik Działu Online